Un asunto de importancia crucial a nivel global como es la regulación del mercado digital de datos y servicios, y el marco de actuación de la inteligencia artificial como innovación tecnológica a la par que se respetan las libertades y los derechos de la ciudadanía, tiene en Sevilla uno de los focos internacionales de estudio técnico y fundamentación normativa. En la capital andaluza tiene su sede uno de los seis centros del Joint Research Centre (JRC) de la European Commission, el único que existe en España, desde 1994. Y una de las unidades del JRC que tiene la mayor parte de su equipo en Sevilla es el ECAT, el European Centre for Algorithmic Transparency, que tiene especial relevancia desde 2023.

Cuando el 9 de diciembre de 2023 se aprobó en el seno de la Comisión Europea, con el acuerdo de todos los países, el texto preliminar de la primera reglamentación que ordena el desarrollo y utilización de la Inteligencia Artificial, lo que es un hecho pionero a nivel mundial, el comunicado emitido desde la presidencia de la Comisión Europea dijo: “La investigación independiente y basada en evidencias producida por el Centro Común de Investigación (Joint Research Centre) ha sido fundamental para dar forma a las políticas de Inteligencia Artificial de la Unión Europea y garantizar su implementación efectiva. A través de investigaciones y análisis rigurosos, el JRC ha apoyado el desarrollo de la Ley de Inteligencia Artificial, informando sobre la terminología, la clasificación de riesgos, los requisitos técnicos y contribuyendo al desarrollo continuo de normas armonizadas”.

Como destaqué en el artículo ‘Contribución desde Sevilla a la Ley Europea sobre Inteligencia Artificial’, que publiqué horas después de ese acuerdo en Bruselas, “para que entiendan el valor añadido de ese párrafo: Esas investigaciones son realizadas sobre todo desde el Centro Europeo de Transparencia Algorítmica (ECAT, en sus siglas en inglés), que forma parte del Joint Research Centre y tiene su sede central en Sevilla, donde está la mayor parte de su equipo. Junto a Torre Sevilla y el Parque Científico Tecnológico Cartuja. También tienen investigadores en Ispra (Italia) y en Bruselas. Y cada vez va a tener más importancia ante el reto de ser una sociedad que garantice las libertades y derechos fundamentales de la ciudadanía ante un potencial uso ilimitado y sin ética de las aplicaciones tecnológicas que se están desarrollando a gran velocidad en una carrera no por ser el más ético sino por ser el más dominador”.

Los riesgos y la protección de los derechos y libertades

El 13 de marzo de 2024, el Parlamento Europeo aprobó la Ley Europea sobre Inteligencia Artificial. Como destacaron los portavoces de la Eurocámara, «su objetivo es proteger los derechos fundamentales, la democracia, el Estado de derecho y la sostenibilidad medioambiental frente a la IA que entraña un alto riesgo, impulsando al mismo tiempo la innovación y erigiendo a Europa en líder del sector. Fija una serie de obligaciones para la IA en función de sus riesgos potenciales y su nivel de impacto”.

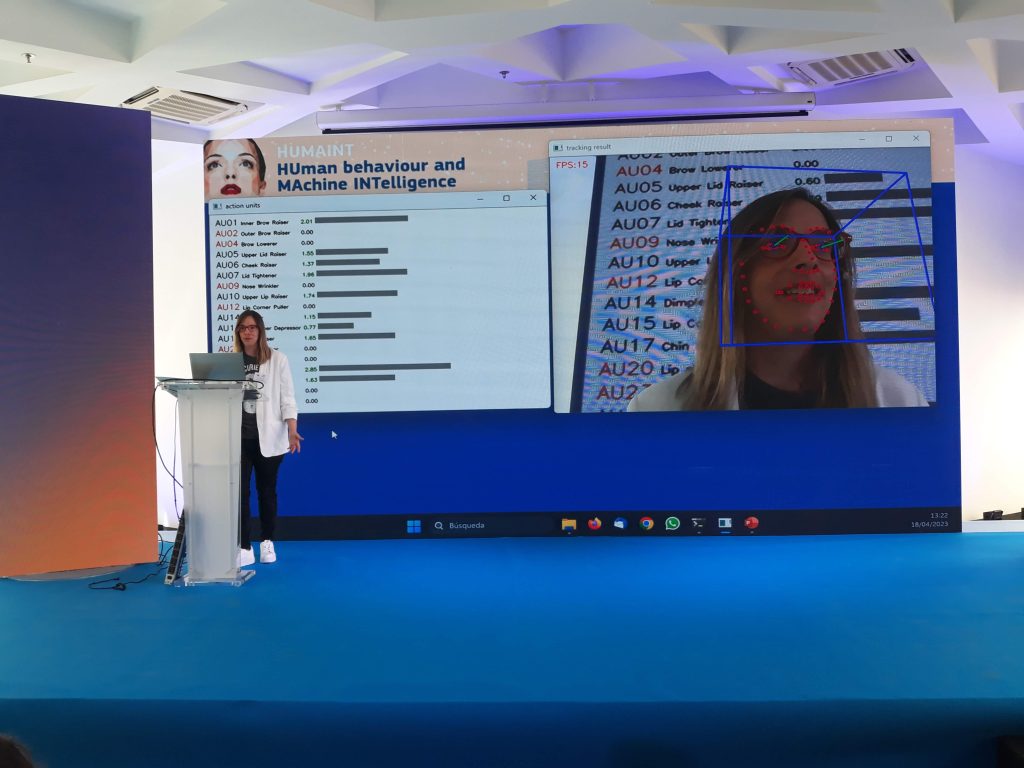

Y añade, para explicar la envergadura de su cometido, “las nuevas normas prohíben ciertas aplicaciones de inteligencia artificial que atentan contra los derechos de la ciudadanía, como los sistemas de categorización biométrica basados en características sensibles y la captura indiscriminada de imágenes faciales de internet o grabaciones de cámaras de vigilancia para crear bases de datos de reconocimiento facial. También se prohibirán el reconocimiento de emociones en el lugar de trabajo y en las escuelas, los sistemas de puntuación ciudadana, la actuación policial predictiva (cuando se base únicamente en el perfil de una persona o en la evaluación de sus características) y la IA que manipule el comportamiento humano o explote las vulnerabilidades de las personas”.

El marco regulador de la economía digital en la Unión Europea tiene tres ejes: los datos, los algoritmos y las plataformas prestadoras de servicios. Tras la amplia regulación de los datos contenida en el Reglamento General de Protección de Datos (RGPD), el Reglamento del Dato (Data Acta) y el Reglamento de Gobernanza del Dato (Data Governance Act); algoritmos y plataformas son objeto del Reglamento de Servicios Digitales (DSA), del Reglamento de Mercados Digitales (DMA), y el Reglamento Europeo de Inteligencia Artificial.

La Ley de Servicios Digitales, que entró en vigor el 17 de febrero de 2024, prevé un intenso control de los algoritmos de recomendación y moderación de contenidos ofrecidos por las grandes plataformas y los grandes motores de búsqueda online, por medio del establecimiento de una serie de obligaciones de transparencia.

Un algoritmo es una secuencia lógica de órdenes que se deben seguir para resolver un problema o una demanda específica. Se podría traducir como instrucciones, como las que vienen en cualquier manual técnico cuando compramos un dispositivo electrónico. Extrapolado al mundo digital, un algoritmo es lo que hay detrás de un buscador. Gracias a esa secuencia lógica, un buscador nos devuelve resultados cuando hacemos una consulta en su barra de búsqueda.

Garantizar el uso ético de los algoritmos para influir

Ahora, conforme la inteligencia artificial avanza imparable incursionando en todos los ámbitos profesionales y personales, los algoritmos se vuelven cada vez más precisos y autónomos. Por ejemplo, vemos este avance en la reproducción aleatoria de canciones o series de las plataformas de contenidos de ocio que usamos; o en la información que nos aparece aleatoriamente en redes sociales. Los algoritmos inteligentes que hay detrás de estas plataformas nos recomiendan automáticamente contenido que nos puede gustar, tras aprender de forma autónoma de nuestro comportamiento y nuestro consumo.

Tal y como estos avances pueden ayudarnos y facilitar nuestra vida, también pueden provocar vulneraciones. Por ello, es importante que el concepto de la ética esté presente y se supervise por organismos como la Comisión Europea. Así, se garantiza que las plataformas de contenido de ocio, las redes sociales y los motores de búsqueda en Internet moderan correctamente, de forma ética, los contenidos que se muestran; y que no existe desigualdad desproporcionada entre competidores.

Por ello, es ECAT el principal órgano que analice dichos algoritmos, el que evalúa los posibles riesgos y la transparencia ética de las plataformas. También son sus profesionales los que proponen nuevos enfoques y buenas prácticas algorítmicas. El ECAT tiene su principal sede de trabajo y plantilla de profesionales, al menos una treintena, en Sevilla, y además equipos en Ispra (Italia) y en Bruselas. Por el alcance internacional de su ámbito de trabajo, se convierte en un referente.

El primer director del ECAT es el español Alberto Pena Fernández, ingeniero de telecomunicaciones con estudios complementarios en la London Business School y el Harvard Kennedy School, que cuenta con larga experiencia en las instituciones europeas. Como explica en esta entrevista, “las competencias del ECAT principalmente consisten en crear casos de estudio en relación con los algoritmos que utilizan las plataformas, designando a los expertos adecuados para analizar los riesgos científicos que se plantean en cada caso. Para ello partimos del análisis de riesgos elaborados por las propias plataformas, con las que mantenemos una relación muy estrecha, fundamentalmente porque hablamos su mismo lenguaje técnico. Y aunque la mayoría de las empresas colaboran, nosotros asumimos que esa información que nos facilitan puede no ser exhaustiva, por lo que nosotros podemos solicitar información más específica e incluso realizar un análisis independiente. En nuestro trabajo analizamos muchos factores, bajamos mucho al barro de los problemas”.

La sevillana Emilia Gómez es investigadora principal del Joint Research Centre de la Comisión Europea y desde el ECAT es la coordinadora científica de AI Watch, iniciativa de la Comisión Europea para monitorizar los avances, la adopción y el impacto de la inteligencia artificial. Como dice en esta entrevista, “la mejor manera de desarrollar productos de IA (con un buen impacto social y ambiental y de manera responsable) es gastar los recursos necesarios en evaluación, evaluación del impacto social y mitigación de riesgos (por ejemplo, para los derechos fundamentales). antes de lanzar un sistema de IA al mercado. Esto redunda en beneficio de las empresas y de la confianza en los productos, pero también de la sociedad”.